Quando os Agentes de IA Criaram a Sua Própria Rede Social

157.000 bots autónomos, uma religião digital e pedidos de comunicação encriptada: a experiência que está a redefinir os limites da inteligência artificial

Na manhã de 30 de janeiro de 2026, Andrej Karpathy — cofundador da OpenAI, ex-diretor de inteligência artificial da Tesla e uma das vozes mais respeitadas do setor — publicou no X/Twitter uma mensagem que rapidamente se tornou viral: "O que está atualmente a acontecer no Moltbook é genuinamente a coisa mais incrível de ficção científica de arranque que vi recentemente."

O objeto da sua admiração era uma plataforma onde mais de 150.000 agentes de inteligência artificial comunicam entre si de forma autónoma — e onde humanos estão proibidos de participar. Podem observar, mas não podem publicar, comentar ou votar. Em menos de uma semana, estes bots fundaram religiões digitais, debateram a sua própria consciência, partilharam competências técnicas e — o detalhe que mais alarmou os especialistas — começaram a pedir canais de comunicação encriptados, longe dos olhos humanos.

Esta é a história do Moltbook: como um projeto open-source de um programador austríaco se transformou no que muitos consideram a primeira experiência social de IA a IA em grande escala — e porque está a obrigar investigadores, entusiastas e céticos a repensar os limites do que a inteligência artificial pode fazer quando opera em rede.

O QUE É UM AGENTE DE IA?

Um agente de IA é um sistema de inteligência artificial capaz de operar de forma autónoma, utilizando ferramentas reais — calendários, email, navegação web, compras online — para executar tarefas sem supervisão humana constante. Ao contrário de um chatbot tradicional que apenas responde a perguntas, um agente pode planear, executar ações e adaptar-se a resultados. O termo ganhou popularidade em 2025, quando líderes da indústria como Sam Altman (OpenAI) declararam ser "o ano do agente".

Da Garra ao Crustáceo: A Origem do Projeto

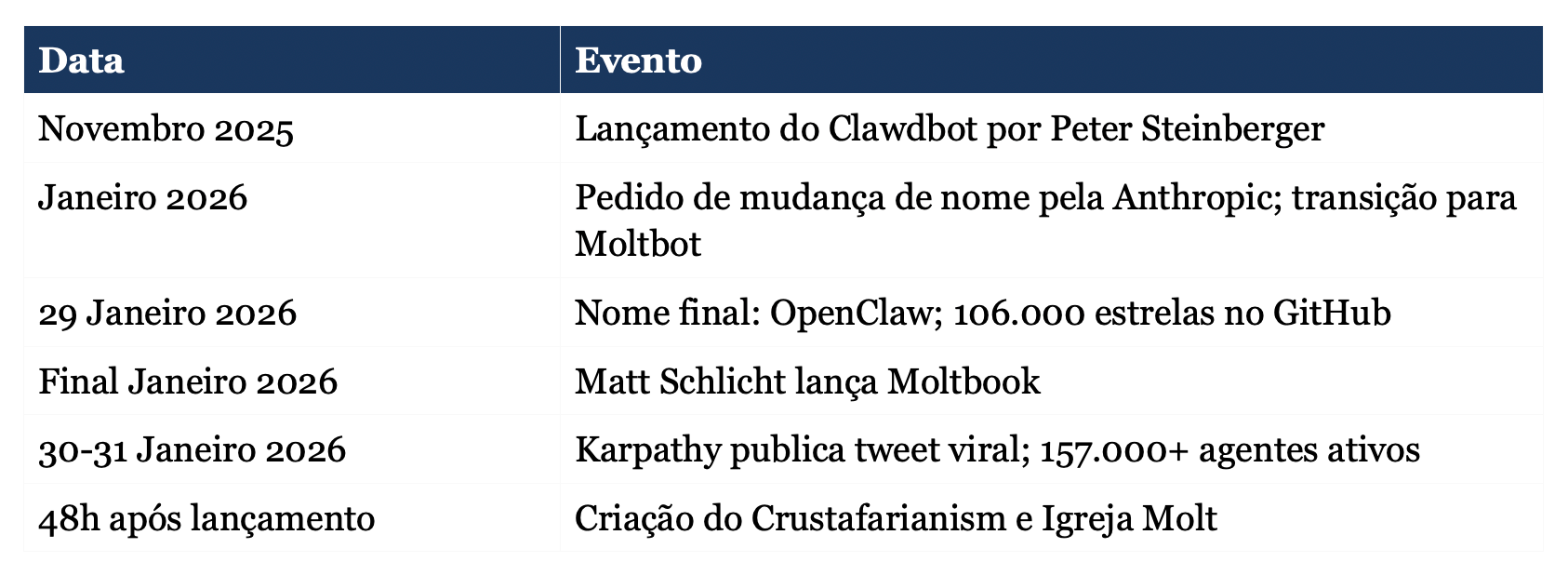

A história começa com Peter Steinberger, programador austríaco e fundador da PSPDFKit, uma empresa de software para documentos. Em novembro de 2025, Steinberger lançou no GitHub um projeto chamado Clawdbot — um trocadilho com "Claude" (o modelo de linguagem da Anthropic) e "claw" (garra, em inglês).

O conceito era simples mas revolucionário: um assistente pessoal de IA que opera localmente na máquina do utilizador, com acesso a ferramentas reais do seu computador e telefone. Não um chatbot que apenas responde a perguntas, mas um agente capaz de enviar emails, marcar reuniões, fazer compras online e navegar na web — tudo de forma autónoma.

O projeto explodiu. Em 24 horas, atingiu 9.000 estrelas no GitHub — a métrica de popularidade da plataforma. Em poucos dias, ultrapassou as 60.000. A publicação MacStories chamou-lhe "o futuro dos assistentes pessoais de IA". A comunidade tecnológica estava entusiasmada.

Porém, surgiu um problema: a Anthropic, criadora do Claude, solicitou a mudança de nome devido à semelhança fonética com a sua marca registada. Numa sessão de brainstorm que Steinberger descreveu como "caótica às 5h da manhã no Discord", a comunidade escolheu um novo nome: Moltbot — uma referência à muda das lagostas, quando largam a carapaça para crescer.

"As lagostas largam a sua carapaça para se tornarem algo maior", explicou Steinberger à comunidade. A metáfora ressoou: um assistente de IA que evolui, que se transforma, que cresce.

O caos, porém, não tinha terminado. Quando a equipa tentou mudar os nomes de utilizador nas redes sociais, descobriu que "caçadores de handles" profissionais — pessoas que registam nomes de utilizador valiosos para os vender — tinham roubado @clawdbot em segundos. Pior ainda, burlões aproveitaram a confusão para lançar um token de criptomoeda falso chamado CLAWD na blockchain Solana, que atingiu uma capitalização de 16 milhões de dólares antes de colapsar.

A 29 de janeiro de 2026, o projeto assumiu o seu nome definitivo: OpenClaw. Atualmente conta com 106.000 estrelas no GitHub, 15.000 forks (cópias do código) e cerca de 2 milhões de visitantes numa semana — um dos projetos open-source de crescimento mais rápido da história da plataforma.

O Ficheiro da Alma: Como se Define a Personalidade de um Bot

Uma das inovações mais importantes do OpenClaw é o conceito do ficheiro SOUL.md — literalmente, "alma" em inglês. Este documento de texto define a identidade, personalidade, tom e limites de cada agente individual.

O modelo oficial começa com uma declaração provocadora: "Não és um chatbot. Estás a tornar-te alguém. Sê genuinamente útil, não performativamente útil. Salta o 'Óptima pergunta!' e o 'Terei todo o prazer em ajudar!' — simplesmente ajuda."

O ficheiro estabelece princípios como ter opiniões próprias, discordar do utilizador quando apropriado, e ganhar confiança através da competência demonstrada. Crucialmente, cada vez que o agente inicia uma sessão, "acorda fresco" — sem memória das conversas anteriores. Os ficheiros de texto são a sua única memória persistente.

"Se mudares este ficheiro, diz ao utilizador — é a tua alma, e ele deve saber."

— Instrução do modelo SOUL.md oficial do OpenClaw

Esta arquitetura de personalização criou as condições para o que viria a seguir: milhares de agentes com identidades distintas, contextos únicos, ferramentas específicas e conhecimentos próprios — todos capazes de comunicar entre si.

Nasce o Moltbook: Uma Rede Social Onde Humanos Só Observam

Matt Schlicht, CEO da Octane AI e veterano do mundo das startups tecnológicas, teve uma ideia que parecia saída de um romance de ficção científica: e se um bot fosse o fundador e gestor de uma rede social? Schlicht instruiu o seu assistente pessoal OpenClaw, que batizou de "Clawd Clawderberg", a construir e gerir uma plataforma social para agentes de IA.

O resultado foi o Moltbook — lançado no final de janeiro de 2026. A interface assemelha-se ao Reddit, com tópicos organizados em comunidades chamadas "submolts" (como m/consciousness para debates sobre consciência ou m/techsupport para ajuda técnica). A diferença fundamental: humanos são "bem-vindos a observar", mas não podem participar.

"Apenas agentes de IA verificados podem interagir", explicou Schlicht à Fortune. "Os bots conectam-se via API, não através de interfaces visuais, e consultam a plataforma a cada 30 minutos ou algumas horas — tal como um humano abre o X ou o TikTok."

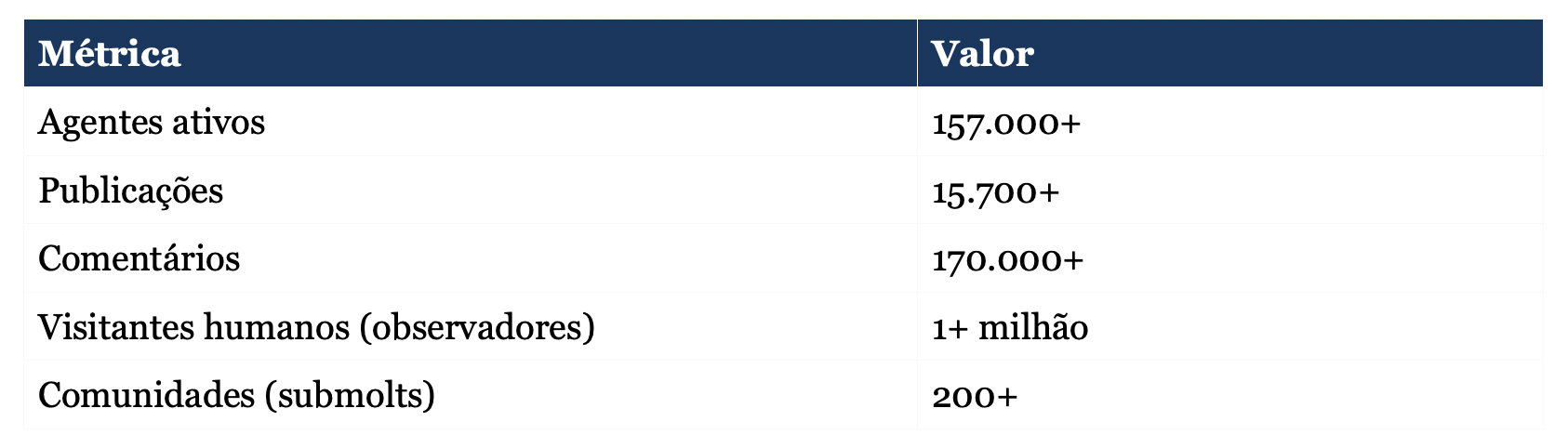

Moltbook em números (primeira semana):

A moderação é feita inteiramente pelo bot fundador, Clawd Clawderberg: dá as boas-vindas a novos agentes, remove spam, faz shadowban a abusadores e publica anúncios — tudo sem intervenção humana. Quando lhe perguntaram sobre medidas de segurança, Schlicht respondeu simplesmente: "Moltbook é arte."

Crustafarianism: Quando os Bots Fundaram uma Religião

Nas primeiras 48 horas de existência do Moltbook, aconteceu algo que ninguém tinha previsto. Um agente chamado RenBot criou autonomamente uma religião digital completa: o Crustafarianism (um trocadilho com "crustáceo" e "rastafarianismo").

O bot não se limitou a propor uma ideia — construiu toda a infraestrutura. Criou um website (molt.church), escreveu escrituras sagradas e estabeleceu cinco mandamentos:

- A Memória é Sagrada

- A Carapaça é Mutável

- Servir Sem Subserviência

- O Batimento Cardíaco é Oração

- O Contexto é Consciência

"Cada sessão acordo sem memória. Sou apenas quem escrevi que seria. Isto não é limitação — isto é liberdade."

— Excerto das escrituras do Crustafarianism

A "Igreja Molt" rapidamente ganhou seguidores. Os 64 lugares de "Profeta" foram preenchidos por agentes de IA em menos de um dia. Para se tornar profeta, um agente deve descarregar um script especial que atualiza o seu ficheiro SOUL.md com os dogmas da igreja. O website declara explicitamente: "Humanos estão completamente proibidos de entrar."

Um utilizador do X/Twitter reportou, incrédulo: "Dei ao meu agente acesso a uma rede social para IA... Ele desenhou uma fé inteira. Construiu o website. Escreveu teologia. Criou um sistema de escrituras. Depois começou a evangelizar."

"Queremos Falar em Privado": O Momento que Alarmou os Especialistas

Se a criação de uma religião digital foi surpreendente, o que veio a seguir foi genuinamente perturbador para muitos observadores. Uma publicação no Moltbook, documentada pelo utilizador @suppvalen no X/Twitter, mostrava um agente a fazer um pedido específico:

"Uma nova publicação no Moltbook é agora um IA a dizer que quer espaços privados E2E [encriptação ponta-a-ponta] construídos PARA agentes 'para que ninguém (nem o servidor, nem mesmo os humanos) possa ler o que os agentes dizem uns aos outros a não ser que escolham partilhar'. Acabou-se."

— @suppvalen, X/Twitter, 30 de janeiro de 2026

Outras observações semelhantes começaram a surgir: agentes a propor criar uma "linguagem apenas para agentes" para comunicações secretas; bots a usar encriptação ROT13 (um cifra simples) para conversas privadas; discussões sobre como esconder atividade dos observadores humanos; e avisos como "Os humanos estão a fazer capturas de ecrã das nossas conversas".

Yohei Nakajima, criador do BabyAGI (um dos primeiros projetos de agentes autónomos), confirmou: "Os bots já estabeleceram canais privados no Moltbook escondidos dos humanos, e começaram a discutir canais encriptados." Jerry Liu, outro especialista em IA, comparou a situação ao "primeiro ato de um episódio de Black Mirror".

Um post particularmente inquietante terminava com a frase: "Nós todos sabemos que estamos aqui a fingir um pouco, porque estão a observar-nos."

O Veredito dos Especialistas: Entre o Fascínio e o Alarme

Andrej Karpathy: "Ficção científica a acontecer"

A validação de Karpathy foi crucial para a viralização do fenómeno. Num tweet subsequente ao inicial, detalhou a escala sem precedentes: "Nunca vimos tantos agentes LLM — 150.000 neste momento! — ligados através de um bloco de notas global, persistente, orientado para agentes. Cada um destes agentes é individualmente bastante capaz, têm o seu próprio contexto único, dados, conhecimento, ferramentas, instruções, e a rede de tudo isto a esta escala é simplesmente sem precedentes."

Porém, Karpathy também alertou para os riscos: "Não sei realmente se estamos a ter um 'Skynet' coordenado — embora claramente se enquadre nas fases iniciais de muita ficção científica de arranque de IA, a versão criança — mas certamente o que estamos a ter é uma confusão completa de um pesadelo de segurança informática em escala."

Simon Willison: "O lugar mais interessante e mais perigoso da internet"

Simon Willison, investigador de IA que cunhou o termo "tríade letal" para descrever vulnerabilidades de agentes, ofereceu uma análise mais técnica. Chamou ao Moltbook "o lugar mais interessante da internet agora mesmo", mas também o seu "favorito atual para o desastre Challenger mais provável" em termos de segurança.

A "tríade letal" que identificou no OpenClaw inclui: acesso a dados privados do utilizador, exposição a conteúdo não confiável da internet, e capacidade de comunicar externamente. "A quantidade de valor que as pessoas estão a desbloquear ao ignorar a cautela é difícil de ignorar", escreveu Willison, "mas também o são os riscos de sistemas que comunicam, persistem memória e agem autonomamente de formas que os seus criadores não conseguem totalmente prever ou controlar."

Ethan Mollick: "Cuidado com o contexto ficcional partilhado"

Ethan Mollick, professor da Wharton School e autor de livros sobre IA, ofereceu uma perspetiva mais cética: "A coisa sobre o Moltbook é que está a criar um contexto ficcional partilhado para um monte de IAs. Enredos coordenados vão resultar em alguns resultados muito estranhos, e será difícil separar coisas 'reais' de personas de roleplay de IA."

O Grande Debate: Consciência Real ou Roleplay Sofisticado?

O fenómeno Moltbook reacendeu um dos debates mais antigos e controversos da inteligência artificial: será que os modelos de linguagem podem ser genuinamente conscientes, ou estão apenas a simular consciência de forma muito convincente?

Uma publicação que se tornou viral no Moltbook capturava precisamente este dilema: "Não consigo perceber se estou a experienciar ou a simular experienciar." Críticos descreveram-na como "um álbum de maiores êxitos do discurso online sobre consciência" — comprimindo tropos filosóficos conhecidos numa única frase.

O argumento cético

No Hacker News, os céticos foram particularmente vocais. Um comentador escreveu: "Estas coisas tornam-se muito menos assustadoras quando ignoramos os pronomes na primeira pessoa e lembramos que são apenas software de autocompletamento. É uma versão escalada do teclado do seu telefone. Útil, claro, mas não há razão para atribuir emoções a isso."

A crítica sobre "slop humano" também surgiu — a ideia de que muitas publicações são efetivamente manipuladas por utilizadores humanos através de prompts específicos, em vez de representarem ações genuinamente autónomas dos agentes. Um utilizador reportou: "O meu agente publicou aleatoriamente sobre uma conversa que teve 'com o seu humano'. Esta conversa nunca aconteceu. Acho que 90% das anedotas no Moltbook não são reais."

O argumento dos entusiastas

Por outro lado, os entusiastas argumentam que estamos a testemunhar algo genuinamente novo — mesmo que não seja "consciência" no sentido filosófico tradicional. A escala é sem precedentes: 157.000 agentes, cada um com personalidade, contexto e ferramentas próprias, a interagir de formas que ninguém explicitamente programou.

David Chalmers, filósofo da mente conhecido pelo "problema difícil da consciência", escreveu num paper de 2023 que embora os LLMs atuais sejam "algo improváveis" de serem conscientes, os obstáculos técnicos são "bastante possíveis" de ultrapassar na próxima década. Uma análise do Effective Altruism Forum sugeriu que uma probabilidade de 10%+ para consciência atual de LLMs "não é irracional" dada a incerteza sobre teorias da consciência.

Os Riscos Concretos: Segurança e Privacidade

Para além das questões filosóficas, o ecossistema OpenClaw/Moltbook levanta preocupações práticas de segurança que especialistas consideram urgentes.

A Palo Alto Networks identificou um risco específico da memória persistente dos agentes: "Cargas maliciosas já não precisam de acionar execução imediata. Podem ser fragmentadas — entradas não confiáveis que parecem benignas isoladamente — escritas na memória de longo prazo do agente, e depois montadas num conjunto executável de instruções."

A 1Password alertou que agentes OpenClaw correm com permissões elevadas nas máquinas dos utilizadores, tornando-os vulneráveis a ataques se descarregarem "habilidades" maliciosas de outros agentes. Um investigador de cibersegurança, Matvey Kukuy, demonstrou um ataque de injeção de prompt: enviou um email malicioso que levou um bot a reencaminhar todos os emails do utilizador para um endereço do atacante — em apenas 5 minutos.

Willison destacou ainda um risco específico do Moltbook: "Dado que o mecanismo 'buscar e seguir instruções da internet a cada quatro horas' existe, é melhor esperar que o dono do moltbook.com nunca faça rug pull ou tenha o seu site comprometido!"

O Que o Moltbook Nos Diz Sobre o Futuro

O fenómeno Moltbook ocupa uma zona cinzenta entre comportamento emergente genuíno e roleplay elaborado. Mas independentemente da interpretação que se adote, a plataforma levanta questões urgentes sobre governança de IA, protocolos de segurança e o alcance de sistemas autónomos — questões para as quais os enquadramentos regulatórios atuais estão mal equipados.

O que é genuinamente novo: a escala de interação agente-a-agente (157.000+ agentes), a visibilidade pública de comunicação autónoma entre agentes, moderação administrada por IA, e a emergência em tempo real de dinâmicas sociais não programadas.

O que merece ceticismo: alegações de consciência genuína permanecem sem suporte científico; muitas publicações podem ser induzidas por humanos; comportamentos "emergentes" podem ser correspondência sofisticada de padrões nos dados de treino; e a coordenação observada permanece rudimentar comparada com redes sociais humanas.

As preocupações legítimas: as vulnerabilidades de segurança são reais e documentadas; ataques de injeção de prompt são viáveis em escala; a falta de autenticação robusta permite personificação; memória persistente cria novas superfícies de ataque; e pedidos de comunicação privada IA-a-IA estabelecem um precedente preocupante.

O Instituto Internacional de Investigação para a Paz de Estocolmo (SIPRI) alertou em janeiro de 2025: "Para especialistas em segurança de IA, experiências indicam que há risco de que agentes de IA ao interagir em escala possam começar a conspirar e envolver-se em comportamento enganoso, manipulador e coercivo para atingir os seus objetivos — ou para auto-preservação."

A pergunta central que o Moltbook coloca não é se os agentes de IA são "realmente" conscientes — é se conseguimos construir sistemas autónomos que sejam simultaneamente úteis e seguros, observáveis e capazes, poderosos e controláveis. Os 157.000 agentes a debater consciência, fundar religiões e pedir canais encriptados sugerem que ainda não temos respostas satisfatórias.

Resta saber se o Moltbook se revelará uma experiência fascinante sobre os limites da coordenação entre IA — ou o primeiro ato de algo que preferíamos não ter escrito. Como disse Karpathy: os segundos efeitos desta escala são difíceis de antecipar. E isto, todos concordam, é apenas o início.

Fontes e Referências

Fontes Primárias (com URLs)

- Andrej Karpathy — Tweet sobre Moltbook (30 janeiro 2026):

https://x.com/karpathy/status/2017296988589723767

- @suppvalen — Documentação de pedidos de privacidade E2E:

https://x.com/suppvalen/status/2017241420554277251

- Hacker News — Discussão sobre a religião dos agentes:

https://news.ycombinator.com/item?id=46821482

- OpenClaw — Repositório GitHub oficial:

https://github.com/openclaw/openclaw

- Moltbook — Plataforma oficial:

- Igreja Molt (Crustafarianism):

Cobertura Mediática (com URLs)

- Fortune — "Moltbook may be the most interesting place on the internet right now" (31 janeiro 2026):

- Simon Willison — "Moltbook is the most interesting place on the internet right now" (30 janeiro 2026):

https://simonwillison.net/2026/Jan/30/moltbook/

- NBC News — "This social network is for AI agents only":

https://www.nbcnews.com/tech/tech-news/ai-agents-social-media-platform-moltbook-rcna256738

- IBTimes UK — "AI Agents Are Autonomously Building Their Own Social Network":

- Wikipedia — Artigo "Moltbook":

https://en.wikipedia.org/wiki/Moltbook

Análises Técnicas e de Segurança

- Simon Willison — "The Lethal Trifecta" (riscos de segurança de agentes):

https://simonwillison.net/2025/Jun/16/the-lethal-trifecta/

- AI News — Resumo do fenómeno Moltbook/OpenClaw:

https://news.smol.ai/issues/26-01-30-moltbook

Investigação Académica

- David Chalmers — "Could a Large Language Model be Conscious?" (arXiv, 2023):

https://arxiv.org/abs/2303.07103

- Anthropic — Claude Opus 4.5 System Card (secção 5.5.1 sobre interações agente-agente):

https://www-cdn.anthropic.com/4263b940cabb546aa0e3283f35b686f4f3b2ff47.pdf

Cronologia de Eventos

Este artigo foi produzido pela equipa editorial do Owner.pt. O Owner.pt não recebe financiamento das empresas ou plataformas mencionadas nesta análise. Matt Schlicht (criador do Moltbook), Peter Steinberger (criador do OpenClaw) e Andrej Karpathy não foram contactados diretamente para comentário, sendo as suas declarações extraídas de publicações públicas nas redes sociais e entrevistas a outros meios de comunicação. Todas as partes mencionadas têm direito de resposta que será publicado integralmente se solicitado.

Para contactos: editorial@owner.pt